语言的未来:深度学习在自然语言处理中的革命

1 引言

自古以来,语言就是人类表达思想、传递信息、进行社会互动的基石。语言的复杂性既体现在其变化多端的语义、句法和语用层面,同时也反映在人类如何理解和产生自然语言的深奥之中。在这一节中,我们将探讨语言的这些复杂性及其在人类交流中的卓越地位。进而,我们将概述自然语言处理(NLP)的演变历程以及深度学习如何引领这一领域的变革。

1.1 讨论语言的复杂性及其对人类交流的重要性

语言是一个高度复杂的系统,它涉及到从音素、词汇、短语、句子乃至话语的多个层面。语言的意义不仅仅局限于单词的字面意思——它还包括隐喻、语境、情绪以及非言语元素等方面。此外,一句话的意思可能会因为文化、情境或个人经历的差异而产生变化。

例如,考虑到英语中的短语“break a leg”,字面上的含义可能会让非英语母语者感到困惑,但在文化语境中,这实际上是一种祝福,意为“祝你好运”。这种语言的多样性和复杂性是自然语言处理(NLP)领域中所面临的一大挑战。

1.2 简述自然语言处理(NLP)的历史和深度学习如何对其产生影响

自然语言处理的历史可以追溯到20世纪50年代,当时的研究主要集中在规则基础的方法上,这要求研究者精心设计语言规则来解析文本和生成回应。然而,由于语言的高度复杂和多变,这些规则基础的系统很难覆盖所有的语言现象,因此很难扩展和维护。

随后,在20世纪90年代,统计学习方法开始崭露头角,它们通过从大量文本数据中学习语言模式,从而克服了规则基础方法的一些限制。然而,即使这些统计方法提高了NLP系统的灵活性,它们仍然局限于浅层的语言特征,无法充分捕捉语言的深层次语义。

直到最近,深度学习的兴起彻底改变了这个领域。深度学习模型,尤其是神经网络,通过其多层次的架构能够捕捉从低级到高级的语言特征。这种从数据中自动学习特征的能力,允许深度学习模型处理自然语言处理任务时展现出前所未有的性能。

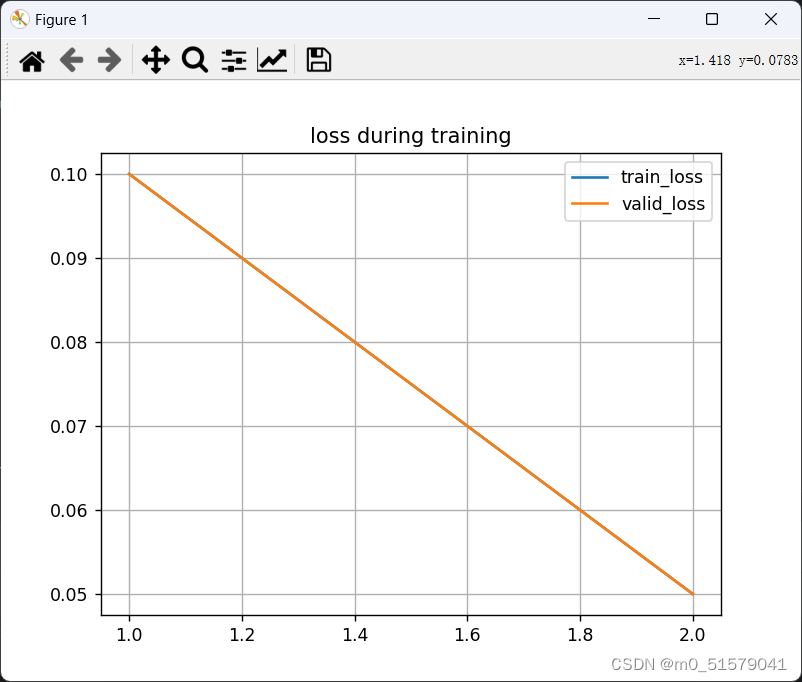

一个重要的概念是损失函数(loss function),它是衡量模型预测和真实数据之间差异的标准。在NLP的背景下,一个常见的损失函数是交叉熵损失(cross-entropy loss),其数学形式可以表示为:

L = − 1 N ∑ i = 1 N ∑ c = 1 M y i , c log ( y ^ i , c ) \mathcal{L} = -\frac{1}{N} \sum_{i=1}^{N} \sum_{c=1}^{M} y_{i,c} \log(\hat{y}_{i,c}) L=−N1i=1∑Nc=1∑Myi,clog(y^i,c)

其中, N N N 代表样本数量, M M M 是类别数, y i , c y_{i,c} yi,c 是第 i i i个样本是否属于类别 c c c的真实标签, y ^ i , c \hat{y}_{i,c} y^i,c 是模型预测样本 i i i属于类别 c c c的概率。

这种损失函数在训练如循环神经网络(RNNs)和Transformer模型等深度学习模型时至关重要。这些模型通过最小化损失函数来调整网络权重,从而更好地进行特征学习和语言理解。

接下来,我们将展开讨论文本预处理的重要性,这是在任何NLP任务中不可或缺的一步。通过这一节内容的铺垫,我们将深入理解深度学习是如何赋予机器理解和生成自然语言的强大能力。

2 文本预处理的重要性

在深入探讨如何通过深度学习方法让机器理解和生成语言之前,我们必须先理解文本预处理的基础。这是所有自然语言处理任务的起点,确保输入数据的质量。本节将详细介绍文本预处理的关键概念,包括它的目标和方法,并通过示例代码和可视化图表来加深理解。

2.1 关键概念:文本预处理的目标与方法

文本预处理的主要目的是将原始文本转换成适合机器学习算法处理的格式。在自然语言处理中,我们通常面对的文本数据是非结构化的,包含了许多对于算法来说是噪声的元素。例如,标点符号、大小写、特殊字符等,这些因素如果不加以处理,会对模型的性能造成不利影响。

文本预处理常见的步骤包括:

- 标准化(Normalization):将文本转换为统一的格式,例如将所有字母转换为小写,删除非标准字符等。

- 分词(Tokenization):将连续的文本字符串分割成单独的单词或词汇单元,这是分析文本的基本步骤。

- 清洗(Cleaning):去除文本中无意义的词汇,如“的”、“是”等停用词(Stop Words),以及去除噪声如HTML标签等。

- 词干提取(Stemming)与词形还原(Lemmatization):通过去掉单词的前后缀来找到词根,或者将单词还原到其词典形式,以减少单词的多样性影响。

- 向量化(Vectorization):将文本转换为数值形式,以便机器学习算法可以处理。这包括词袋(Bag-of-Words)、TF-IDF等方法。

要说明的一个关键点是,这些步骤并非孤立执行,而是相互依赖,通常需要按照特定顺序进行。例如,标准化通常是第一步,因为它为后续步骤创建了一个干净的工作环境。

2.2 实例代码:Python中实现文本清洗

为了具体理解文本预处理的过程,让我们通过一段Python代码来演示如何进行文本清洗。

import re

import nltk

from nltk.corpus import stopwords

from nltk.stem import WordNetLemmatizer

# 初始化停用词列表和词形还原器

nltk.download('stopwords')

nltk.download('wordnet')

stop_words = set(stopwords.words('english'))

lemmatizer = WordNetLemmatizer()

def clean_text(text):

# 转为小写

text = text.lower()

# 移除特殊字符和数字

text = re.sub(r'[^a-z]', ' ', text)

# 分词

tokens = text.split()

# 移除停用词并进行词形还原

tokens = [lemmatizer.lemmatize(word) for word in tokens if not word in stop_words]

# 重新组合为字符串

return ' '.join(tokens)

# 示例文本

raw_text = "Deep learning (also known as deep structured learning) is part of a broader family of machine learning methods!"

cleaned_text = clean_text(raw_text)

print(cleaned_text)

执行上述代码,我们可以得到经过清洗的文本:“deep learning also known deep structured learning part broader family machine learning method”,这个文本相比原始文本更适合作为机器学习模型的输入。

2.3 可视化图表:原始数据与处理后数据的比较

为了更直观地理解文本预处理的效果,我们可以使用可视化手段来展示原始数据和处理后数据的区别。这可以通过绘制词频直方图来实现。

假设我们有以下两个文本集合,一个是原始文本集合,另一个是经过预处理的文本集合。我们可以使用Python中的matplotlib库来绘制两个集合中最常见单词的词频直方图。

import matplotlib.pyplot as plt

from collections import Counter

# 假设经过预处理和未经处理的文本集合

raw_texts = [raw_text, "Another example sentence with some different words!"]

cleaned_texts = [cleaned_text, clean_text(raw_texts[1])]

# 统计词频

raw_freq = Counter(" ".join(raw_texts).split())

cleaned_freq = Counter(" ".join(cleaned_texts).split())

# 绘图

def plot_word_frequency(word_freq, title):

words, counts = zip(*word_freq.most_common(10))

plt.bar(words, counts)

plt.title(title)

plt.xticks(rotation=45)

plt.show()

plot_word_frequency(raw_freq, 'Top Words in Raw Text')

plot_word_frequency(cleaned_freq, 'Top Words in Cleaned Text')

通过比较两个直方图,我们可以清楚地看到原始文本中包含许多常见的、但对于文本含义理解并不重要的单词(如“is”、“of”)。而在经过清洗的文本中,这些单词的频率显著降低,同时与主题更相关的单词(如“learning”、“machine”)的频率相对增加。

总结一下,文本预处理是自然语言处理中不可或缺的一步。它涉及到多个步骤,包括文本标准化、分词、清洗、词干提取和词形还原以及向量化。通过预处理,我们可以确保输入数据的质量,为后续的机器学习任务打下坚实的基础。接下来的部分,我们将探讨如何将这些预处理过的文本转换为机器可以理解的数值形式——词嵌入。

3 词嵌入——单词的数值转换术

在深入探讨词嵌入之前,我们需要理解它在自然语言处理(NLP)中的地位。词嵌入不仅是将单词转换为向量的技术,而是一种可以让计算机理解和操作语言的方式。想象一下,每个单词不再是孤立的字符序列,而是在多维空间中有着丰富含义的点——这些点的相对距离和方向编码了词语之间的语义和语法关系。

3.1 关键概念:词嵌入的意义和不同类型(如Word2Vec, GloVe)

词嵌入是自然语言处理的基石,是一种将词汇映射到高维空间的技术。这种映射捕捉了单词的语义和语法属性,并以向量的形式表示,使得机器学习模型可以理解单词之间的关系。

Word2Vec 是最早期也是最著名的词嵌入方法之一。它通过两种架构——连续词袋(CBOW)和Skip-gram——训练单词向量。在CBOW中,模型预测当前单词基于其上下文;而在Skip-gram中,模型则预测上下文基于当前单词。数学上,Word2Vec模型通过最大化以下对数似然函数来训练:

L = 1 T ∑ t = 1 T ∑ − c ≤ j ≤ c , j ≠ 0 log p ( w t + j ∣ w t ) \mathcal{L} = \frac{1}{T} \sum_{t=1}^{T} \sum_{-c \leq j \leq c, j \neq 0} \log p(w_{t+j}|w_t) L=T1t=1∑T−c≤j≤c,j=0∑logp(wt+j∣wt)

其中, ( w t ) ( w_t ) (wt) 表示目标单词, ( w t + j ) ( w_{t+j} ) (wt+j) 表示上下文单词,( c ) 表示上下文窗口大小,( T ) 是训练语料中的单词总数。

GloVe(全局向量的词表示)是另一种流行的词嵌入方法,不同于Word2Vec的预测模型,GloVe是基于统计信息的。它在全局词频统计的基础上训练词向量,以更好的捕捉单词之间的共现关系。GloVe模型的目标是最小化以下损失函数:

J = ∑ i , j = 1 V f ( X i j ) ( w i T w ~ j + b i + b ~ j − log X i j ) 2 J = \sum_{i,j=1}^{V} f(X_{ij}) (w_i^T \tilde{w}_j + b_i + \tilde{b}_j - \log X_{ij})^2 J=i,j=1∑Vf(Xij)(wiTw~j+bi+b~j−logXij)2

其中, ( X i j ) ( X_{ij} ) (Xij) 表示单词 ( i ) 和 ( j ) 共同出现在一个上下文中的次数,( V ) 是词汇量的大小,( w ) 和 ( w ~ ) ( \tilde{w} ) (w~) 是单词向量,( b ) 和 ( b ~ ) ( \tilde{b} ) (b~) 是偏置项,( f ) 是权重函数,通常用来避免对极少数共现赋予过多的权重。

3.2 实例代码:使用gensim库训练Word2Vec模型

要在Python中使用gensim库训练Word2Vec模型,我们首先需要预处理文本数据,将文本分割成单词列表。接着,我们可以使用gensim的API来定义和训练模型:

from gensim.models import Word2Vec

sentences = [['this', 'is', 'a', 'sentence'], ['this', 'is', 'another', 'sentence']]

model = Word2Vec(sentences, vector_size=100, window=5, min_count=1, workers=4)

model.train(sentences, total_examples=model.corpus_count, epochs=10)

这里的 vector_size 参数定义了词向量的维度,window 定义了上下文窗口的大小,min_count 定义了单词最小出现次数,workers 定义了训练的线程数。

3.3 可视化图表:词嵌入向量空间的2D映射

虽然词嵌入通常存在于高维空间中,但我们可以使用降维技术,如t-SNE(t分布随机邻域嵌入)或PCA(主成分分析),将它们映射到2D或3D空间以便可视化。

例如,给定一组词向量,我们可以使用以下t-SNE代码来降维并绘制它们:

from sklearn.manifold import TSNE

import matplotlib.pyplot as plt

# 假设word_vectors是一个单词到其向量的映射字典

keys = list(word_vectors.keys())

embeddings = [word_vectors[word] for word in keys]

tsne = TSNE(n_components=2, random_state=0)

embeddings_2d = tsne.fit_transform(embeddings)

# 绘制结果

plt.figure(figsize=(16, 9))

for i, key in enumerate(keys):

plt.scatter(embeddings_2d[i, 0], embeddings_2d[i, 1])

plt.annotate(key, (embeddings_2d[i, 0], embeddings_2d[i, 1]), fontsize=9)

plt.show()

这样的可视化不仅可以展示出单词之间的相似性,还能揭示潜在的语义和语法结构。例如,在这样的2D映射中,我们常常能看到国家名聚在一起,动词的不同形态聚在一起,形容词的比较级和最高级聚在一起,等等。

通过上述讨论和示例,我们可以看到词嵌入是建立机器对语言理解的桥梁。接下来的章节中,我们将进一步探讨如何将这些嵌入应用于更复杂的NLP模型中。

4 Transformer与注意力机制——NLP的改革者

在深度学习和自然语言处理(NLP)的领域,Transformer模型和注意力机制的出现无疑是一个革命性的进步。在这一节中,我们将深入探讨Transformer架构的工作原理,特别是自注意力(self-attention)机制的数学基础和它在文本分类等任务中的应用。

4.1 关键概念:Transformer架构和自注意力的工作原理

Transformer模型最早由Vaswani等人在2017年的论文《Attention Is All You Need》中提出,它完全基于注意力机制,摒弃了之前流行的循环神经网络(RNNs)和卷积神经网络(CNNs)的结构。Transformer的核心思想是利用自注意力机制处理序列数据。

自注意力机制的目的是使模型能够关注输入序列中不同位置的信息。在自注意力中,对于序列中的每个元素,模型都会计算它与序列中其他所有元素的关联度。数学上,这是通过一系列的矩阵操作来完成的。

每个输入元素(比如一个单词)首先被转换为三个向量——一个查询向量(Query, Q)、一个键向量(Key, K)和一个值向量(Value, V)。这些向量是通过将输入向量与对应的权重矩阵相乘得到的:

Q

=

X

W

Q

Q = XW^Q

Q=XWQ

K

=

X

W

K

K = XW^K

K=XWK

V

=

X

W

V

V = XW^V

V=XWV

其中, ( X ) (X) (X) 是输入的嵌入向量序列, ( W Q ) (W^Q) (WQ)、 ( W K ) (W^K) (WK) 和 ( W V ) (W^V) (WV) 是模型学习的参数。

自注意力的下一步是计算输入序列中每个元素对于其他元素的注意力权重。这是通过计算查询向量和键向量的点积,然后应用一个softmax函数来实现的:

Attention ( Q , K , V ) = softmax ( Q K T d k ) V \text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V Attention(Q,K,V)=softmax(dkQKT)V

这里, ( d k ) (d_k) (dk) 是键向量的维度,点积后除以 ( d k ) (\sqrt{d_k}) (dk) 是为了防止计算结果过大导致梯度消失的问题。softmax函数确保了所有的权重加起来等于1,这样我们就能得到一个概率分布,表示各个元素之间的关联度。

在Transformer模型中,这个自注意力机制被扩展为多头注意力。即,通过并行地执行多个自注意力机制(每个称为一个“头”),模型能够在不同的表示空间中捕捉序列的不同方面。最后,多头注意力的输出被拼接并进行线性变换:

MultiHead

(

Q

,

K

,

V

)

=

Concat

(

head

1

,

.

.

.

,

head

h

)

W

O

\text{MultiHead}(Q, K, V) = \text{Concat}(\text{head}_1, ..., \text{head}_h)W^O

MultiHead(Q,K,V)=Concat(head1,...,headh)WO

where head

i

=

Attention

(

Q

W

i

Q

,

K

W

i

K

,

V

W

i

V

)

\text{where head}_i = \text{Attention}(QW^Q_i, KW^K_i, VW^V_i)

where headi=Attention(QWiQ,KWiK,VWiV)

在这里,(W^O) 是另一个可学习的权重矩阵, ( head i ) (\text{head}_i) (headi) 是第 (i) 个注意力“头”的输出。

Transformer的另一个关键组件是位置编码。由于自注意力机制本身并不涉及序列的顺序信息,Transformer需要添加位置编码到每个输入嵌入中,以保持位置信息。通常采用的位置编码是一种正弦波函数,它可以产生一个唯一的位置编码:

P

E

(

p

o

s

,

2

i

)

=

sin

(

p

o

s

1000

0

2

i

/

d

model

)

PE_{(pos, 2i)} = \sin\left(\frac{pos}{10000^{2i/d_{\text{model}}}}\right)

PE(pos,2i)=sin(100002i/dmodelpos)

P

E

(

p

o

s

,

2

i

+

1

)

=

cos

(

p

o

s

1000

0

2

i

/

d

model

)

PE_{(pos, 2i+1)} = \cos\left(\frac{pos}{10000^{2i/d_{\text{model}}}}\right)

PE(pos,2i+1)=cos(100002i/dmodelpos)

其中, ( p o s ) (pos) (pos) 是位置索引,( i ) 是维度索引, ( d model ) ( d_{\text{model}} ) (dmodel) 是模型中所有层的输出维度。

4.2 实例代码:基于Transformer的文本分类

假设我们正在处理一个文本分类任务,目标是根据评论文本将其分类为正面或负面。以下是使用基于Transformer的模型进行文本分类的伪代码示例:

from transformers import BertTokenizer, BertForSequenceClassification

import torch

# 初始化分词器和模型

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForSequenceClassification.from_pretrained('bert-base-uncased')

# 编码输入文本

inputs = tokenizer("This is an example of text classification.", return_tensors="pt")

# 获取分类标签

labels = torch.tensor([1]).unsqueeze(0) # Batch size 1, label for 'positive'

# 模型前向传播,计算损失

outputs = model(**inputs, labels=labels)

loss = outputs.loss

logits = outputs.logits

# 这里的loss可以用来在训练过程中反向传播,而logits则用于预测分类

这段代码使用了Hugging Face的Transformers库,这是一个广泛使用的开源库,提供了许多预训练的Transformer模型。

4.3 可视化图表:注意力权重的热力图

为了直观理解模型是如何关注输入序列中不同部分的,注意力权重的可视化是非常有用的。我们可以通过绘制所谓的热力图来实现这一点。热力图中的每个单元格显示了序列中一个单词对另一个单词的注意力程度。下面是一个简单的例子,说明如何使用Matplotlib库来绘制这样的热力图:

import matplotlib.pyplot as plt

import numpy as np

# 假设attention_weights是从模型中获得的注意力权重矩阵,形状为(序列长度, 序列长度)

attention_weights = np.random.rand(10, 10) # 这里使用随机数据作为例子

# 绘制热力图

plt.matshow(attention_weights, cmap='viridis')

plt.colorbar()

plt.show()

这个热力图能够显示模型在处理每个单词时分配给其他单词的注意力程度。在实际的NLP任务中,这样的可视化有助于我们理解模型的决策过程和可能的问题。

通过深入理解Transformer模型和自注意力机制的工作原理,我们能够更好地把握深度学习在自然语言处理中的最新进展。下一节,我们将继续探讨如何将这些概念应用到构建一个智能聊天机器人的实战项目中。

5 实战演练——构建智能聊天机器人

在自然语言处理(NLP)的领域中,实现一个可以模拟人类进行对话的智能聊天机器人一直是一个引人入胜的挑战。本节的目标是深入探讨如何构建一个基于深度学习的聊天机器人,并提供代码示例和可视化工具以增进理解。

5.1 定义项目目标和数据准备

构建聊天机器人的第一步是明确项目的目标。我们的目标是创建一个可以理解自然语言并作出合理回应的模型。这个模型应当能够处理各种话题的对话,且回答尽可能自然、准确。

数据准备涉及到收集和预处理对话数据集。理想的数据集应包含多种对话情景和丰富的用语表达。数据预处理的步骤通常包括:去除噪声、归一化文本、分词和构建词汇表。预处理后,数据将被切分成训练集、验证集和测试集,以便模型的训练、调优和评估。

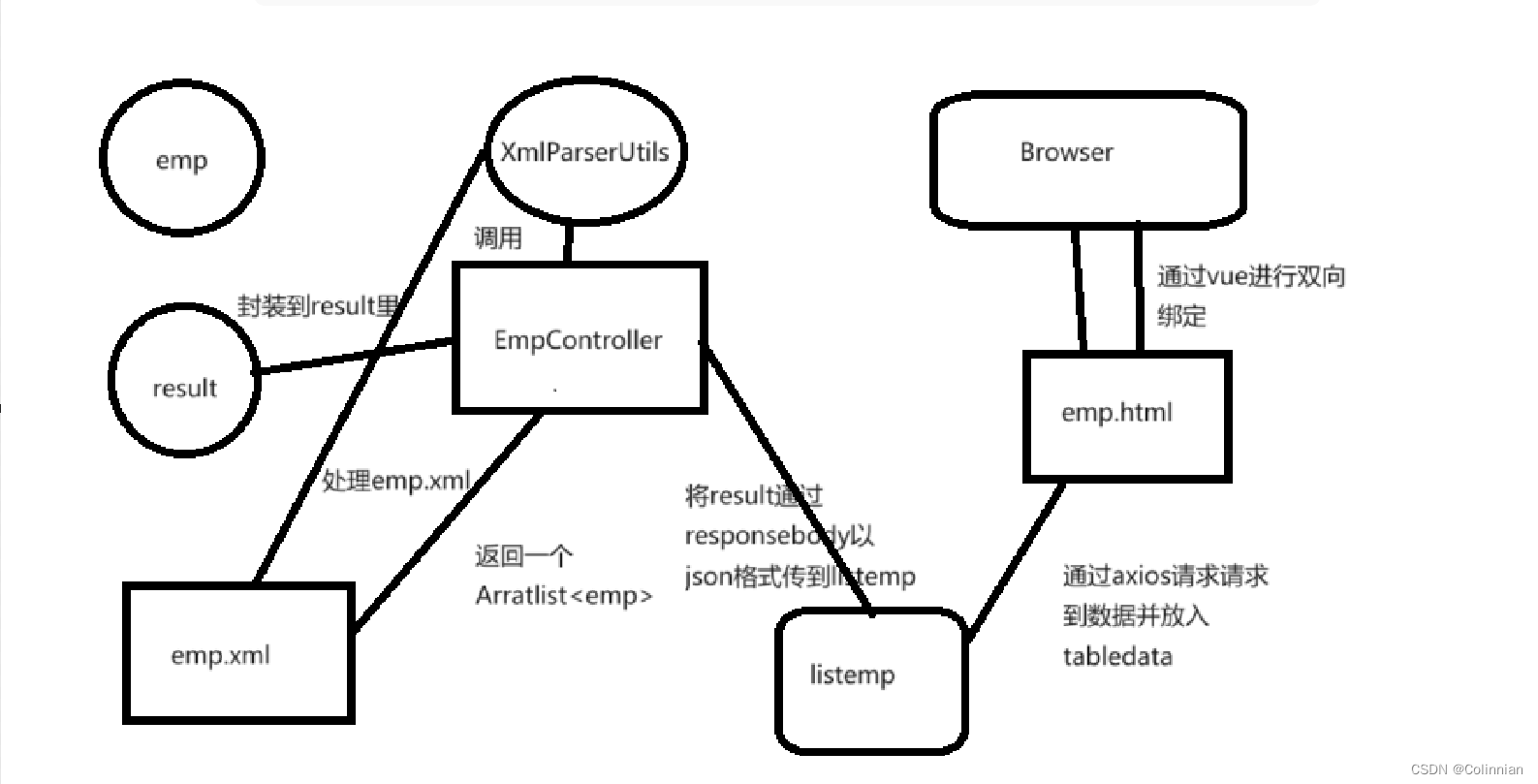

5.2 聊天机器人的总体架构

聊天机器人的架构通常基于序列到序列(Seq2Seq)模型,该模型包括一个编码器和一个解码器。编码器处理输入序列(用户的话语),而解码器生成输出序列(机器人的回答)。这种架构经常配合注意力机制使用,以便更好地聚焦于输入序列中的重要部分。

Seq2Seq Model : Encoder: X → Z Decoder: Z → Y \text{Seq2Seq Model}:\quad \begin{align*} \text{Encoder:} & \quad X \to Z \\ \text{Decoder:} & \quad Z \to Y \end{align*} Seq2Seq Model:Encoder:Decoder:X→ZZ→Y

其中,(X) 是输入序列,(Z) 是编码器的隐藏状态,(Y) 是输出序列。

5.3 实例代码:使用TensorFlow或PyTorch构建序列到序列模型

这里我们选择使用PyTorch构建我们的Seq2Seq模型。首先,我们定义编码器和解码器的网络结构:

import torch

import torch.nn as nn

import torch.optim as optim

class EncoderRNN(nn.Module):

def __init__(self, input_size, hidden_size):

super(EncoderRNN, self).__init__()

self.hidden_size = hidden_size

self.embedding = nn.Embedding(input_size, hidden_size)

self.gru = nn.GRU(hidden_size, hidden_size)

def forward(self, input, hidden):

embedded = self.embedding(input).view(1, 1, -1)

output, hidden = self.gru(embedded, hidden)

return output, hidden

class DecoderRNN(nn.Module):

def __init__(self, hidden_size, output_size):

super(DecoderRNN, self).__init__()

self.hidden_size = hidden_size

self.embedding = nn.Embedding(output_size, hidden_size)

self.gru = nn.GRU(hidden_size, hidden_size)

self.out = nn.Linear(hidden_size, output_size)

self.softmax = nn.LogSoftmax(dim=1)

def forward(self, input, hidden):

output = self.embedding(input).view(1, 1, -1)

output = F.relu(output)

output, hidden = self.gru(output, hidden)

output = self.softmax(self.out(output[0]))

return output, hidden

以上代码段定义了编码器和解码器的基本结构,其中使用GRU(门控循环单元)作为循环神经网络的基础。接下来是训练过程,它涉及到多个迭代,每次迭代都会对模型的参数进行优化:

encoder = EncoderRNN(input_lang.n_words, hidden_size).to(device)

decoder = DecoderRNN(hidden_size, output_lang.n_words).to(device)

encoder_optimizer = optim.SGD(encoder.parameters(), lr=0.01)

decoder_optimizer = optim.SGD(decoder.parameters(), lr=0.01)

criterion = nn.NLLLoss()

for epoch in range(num_epochs):

for i, (input_tensor, target_tensor) in enumerate(training_pairs):

encoder_hidden = encoder.initHidden()

encoder_optimizer.zero_grad()

decoder_optimizer.zero_grad()

loss = 0

# Encoder

for ei in range(input_tensor.size(0)):

encoder_output, encoder_hidden = encoder(input_tensor[ei], encoder_hidden)

decoder_input = torch.tensor([[SOS_token]], device=device)

# Decoder

decoder_hidden = encoder_hidden

for di in range(target_tensor.size(0)):

decoder_output, decoder_hidden = decoder(decoder_input, decoder_hidden)

loss += criterion(decoder_output, target_tensor[di])

decoder_input = target_tensor[di] # Teacher forcing

loss.backward()

encoder_optimizer.step()

decoder_optimizer.step()

print('Epoch [{}/{}], Loss: {:.4f}'.format(epoch+1, num_epochs, loss.item() / target_tensor.size(0)))

上面的代码段演示了一个简单的训练循环,其中包括错误反向传播和参数更新。

5.4 可视化图表:聊天机器人的对话流程图

为提升我们对聊天机器人工作流程的理解,让我们来看一个可视化的对话流程图。这个图表展示了用户输入、编码器处理、解码器响应以及机器人输出的整个过程:

用户输入 -> |编码器| -> 编码状态 -> |解码器| -> 机器人输出

在实际实践中,这个流程图可以通过使用工具如TensorBoard来实现,它能让我们观察到各个阶段的活动和网络中的注意力分布。

总结起来,构建一个智能聊天机器人是一个涉及多个领域知识的复杂任务,但随着深度学习的发展,我们已经能够创建出越来越复杂和准确的模型。在编码器-解码器架构的基础上,融入注意力机制能够显著提升模型对语言的理解和生成能力。通过实践和迭代,我们可以不断改进模型,使其更加贴近人类的交流方式。

6 结语

总结自然语言处理在深度学习领域的重要性和潜力

在本篇文章的开篇,我们深入探讨了语言的复杂性及其对人类交流的不可或缺的作用。从古至今,语言一直是文明进步的基石,而现代科技的发展使我们有机会以前所未有的方式理解和使用语言。自然语言处理(NLP)正是这种探索的前沿,它是一门集多学科之大成的领域,旨在让机器能够理解和生成人类语言。

自深度学习技术兴起以来,NLP领域取得了飞速发展,各种模型如Word2Vec、GloVe和Transformer等不仅推动了语言模型的精确度,也大幅拓宽了应用场景。深度学习为处理大规模语言数据提供了强大的工具,它依赖于多层的神经网络来自动学习语言的复杂特征,无需人工设计特定的规则。同时,这些模型之所以强大,在于它们能够学习到单词、短语、句子甚至篇章的抽象表示。

文本预处理作为深度学习模型训练的前提步骤,确保模型能够接收干净、规范化的数据,提升了模型学习的效率和质量。词嵌入技术将文本转换成计算机更易于处理的数值形式,为后续的深度学习任务打下了基础。Transformer模型和注意力机制的提出,正是对词嵌入技术的进一步演进,它们使模型能够关注到句子中最相关的部分,产生更精确的语言表示,这一突破性进展使得NLP在理解和生成复杂文本方面迈出了重要一步。

接着通过实战演练,我们不仅理论上分析了构建智能聊天机器人的总体架构,还提供了具体的代码示例和可视化工具。这样的练习能让读者从实践中学习和掌握深度学习在NLP中的应用。

现在,让我们回到了文章的结尾,深度学习已经并将继续在语言理解和生成方面扮演至关重要的角色。我们目睹了这一领域的迅猛进展,但同时也应该认识到,尽管取得了显著的成就,NLP依然是一个充满挑战的领域。语言的多样性和复杂性意味着总有新的问题等待解决,总有新的界限等待拓展。

在NLP领域,深度学习的潜力远未被完全挖掘。例如,当前的模型虽然在句子层面的理解上取得了较好的效果,但在更高层次的理解——如篇章、对话和情感分析——上仍需改进。此外,深度学习模型的可解释性也是一个重要研究领域。我们需要更好地了解模型如何做出决策,以及如何使模型的决策过程更加透明。

作为读者,您可以继续深入研究NLP的各个方面,探索新的模型和方法。实践是进步的阶梯,无论是通过调整模型参数、尝试新的网络架构,还是创新数据预处理方法,您的实验都有可能推动这个领域向前发展。

继续探索和实践

本文的目的不仅是为了介绍深度学习在NLP中的应用,更是为了激励您继续在这一领域中探索。每一个新的发现都可以为我们解锁语言的新层次,增进机器与人类的交流。无论您是学术界的研究人员,还是工业界的工程师,或者是对人工智能充满好奇的学习者,您都可以参与到这一领域中来,贡献自己的力量。

深度学习和NLP是一场持续的革命,它正不断地突破界限,扩展我们与技术互动的方式。它不仅仅是科技的发展,更是人类文明发展的一个新篇章。让我们一起期待并创造这个领域的未来吧。

最后,记得学习是一个不断迭代的过程。不要害怕错误,不要害怕失败。每一次尝试,无论成功与否,都是向前迈出的一步。继续学习,继续实践,不断探索这个令人兴奋的人工智能时代的无限可能。

![[Meachines][Easy]Headless](https://img-blog.csdnimg.cn/img_convert/9c5f5a228c376eae770072abd6155e9c.jpeg)